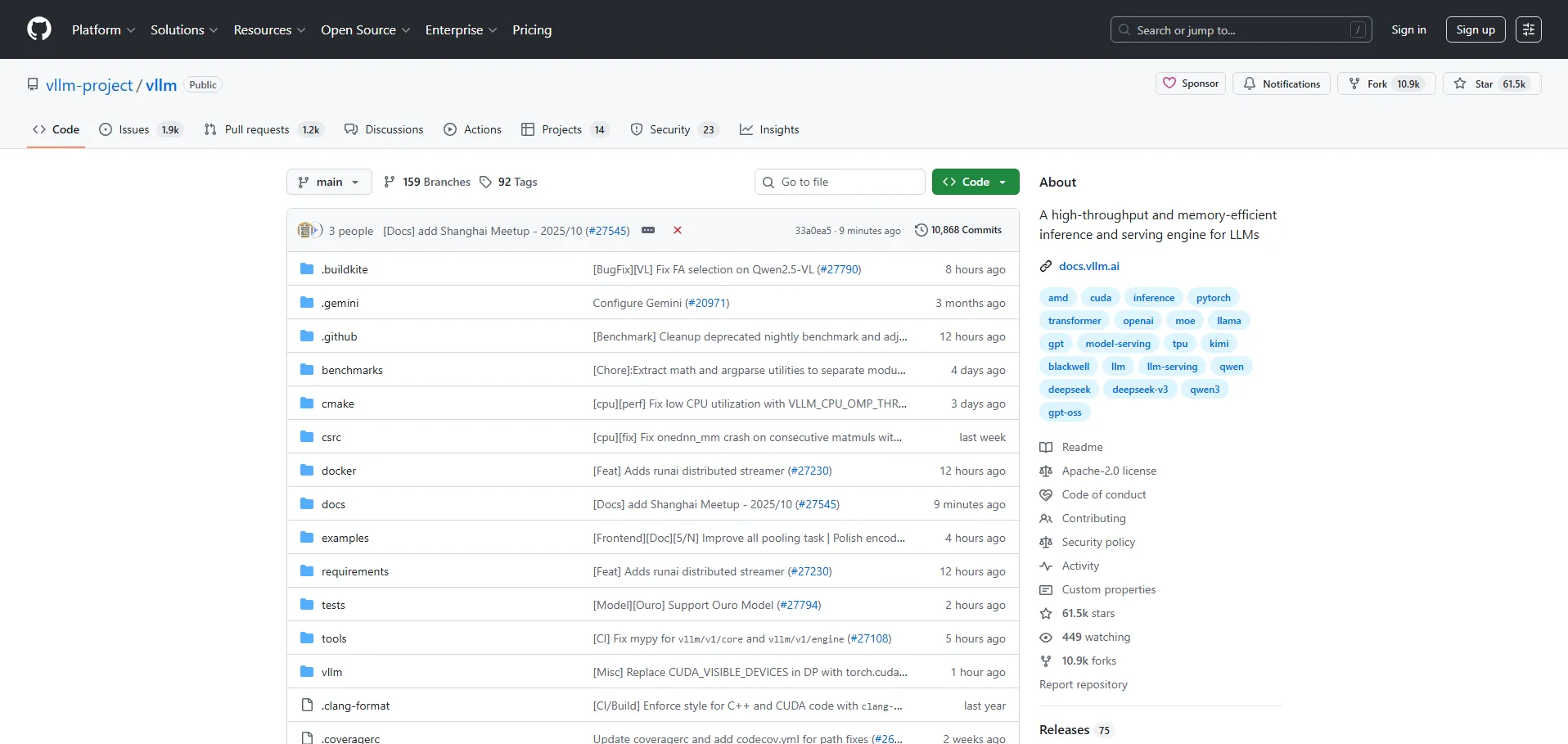

VLLM es un motor de inferencia de alto rendimiento y eficiente en el uso de memoria, diseñado específicamente para Modelos de Lenguaje Grandes (LLM). Optimiza la capacidad de servir modelos extensos mediante una gestión avanzada de recursos, ofreciendo respuestas más rápidas sin comprometer la integridad del rendimiento. Su arquitectura soporta configuraciones multinodo, lo que garantiza escalabilidad y balance de carga en picos de demanda. Además, es compatible con múltiples entornos de implementación, desde nubes públicas hasta infraestructuras on-premise, facilitando su adopción por equipos de todos los tamaños.

🔹 Ingenieros de machine learning: que buscan optimizar la inferencia de modelos grandes.

🔹 Científicos de datos: interesados en desplegar LLMs con bajo consumo de memoria.

🔹 Startups tecnológicas: que requieren soluciones escalables sin invertir en infraestructura compleja.

🔹 Equipos de DevOps: encargados de gestionar despliegues de IA de alta demanda.

🔹 Empresas con flujos de trabajo de IA: que necesitan integrar inferencia eficiente en producción.

📌 Código abierto: gratuito y disponible bajo licencia MIT.

Nota : Los precios están sujetos a cambios. Consulta siempre la información actualizada directamente en el sitio oficial de VLLM

Visita el repositorio en GitHub para acceder al código fuente, documentación detallada y guías de integración. Únete a la comunidad en Discord para recibir soporte, compartir casos de uso y seguir novedades sobre actualizaciones y mejoras.

Ultimas IAS Listadas

Otras recomendaciones

Apúntate ya

Newsletter!