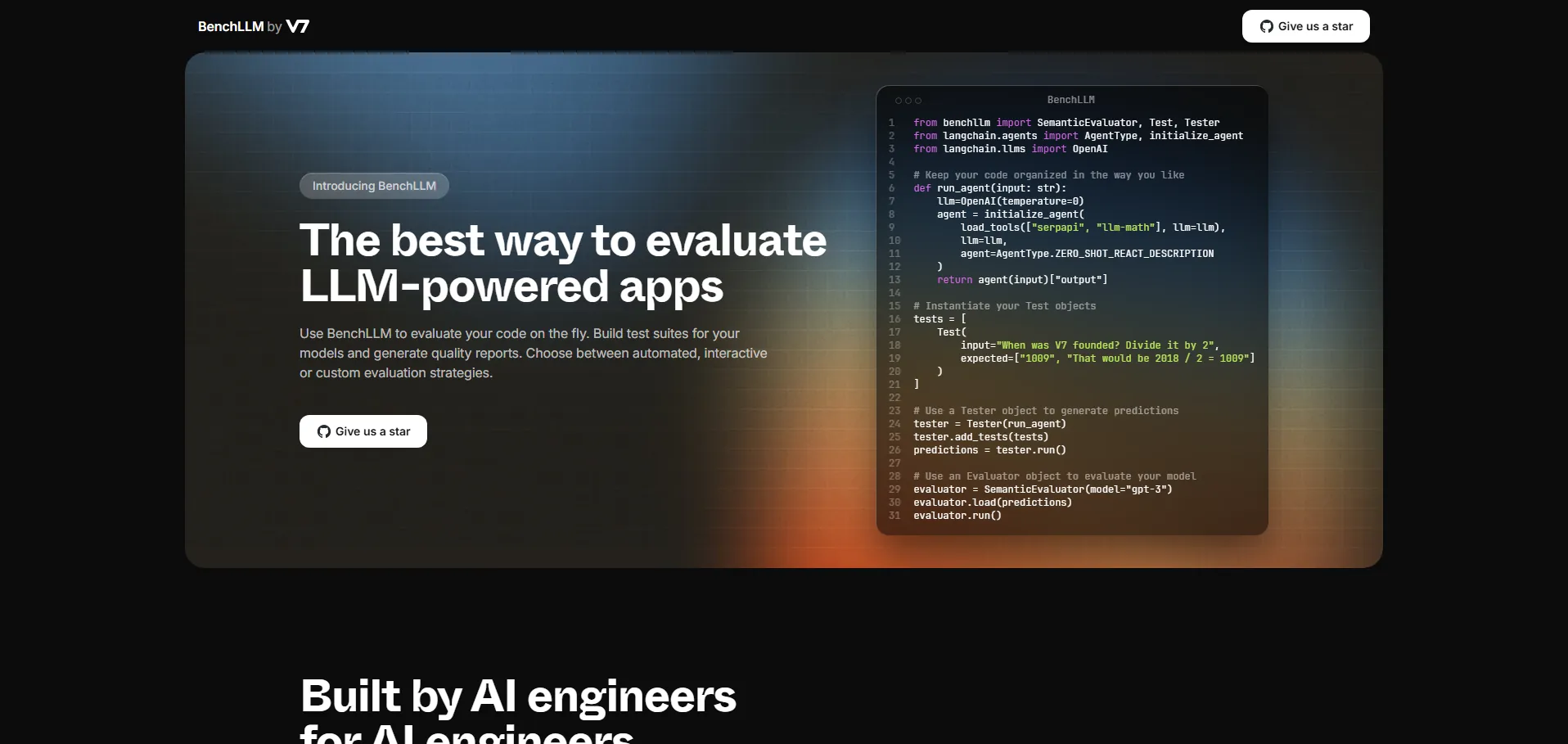

BenchLLM es una herramienta de evaluación de inteligencia artificial especializada en aplicaciones basadas en LLM (Large Language Models). Permite implementar estrategias de evaluación automatizadas, interactivas o totalmente personalizadas, importando objetos semánticos para pruebas y testers. Gracias a su integración con OpenAI, Langchain.agents, Langchain.llms y API Box, ofrece una ejecución de pruebas ágil mediante comandos CLI y genera informes de calidad detallados. Además, facilita la monitorización del rendimiento de los modelos en producción y la detección rápida de regresiones, ayudando a equipos de IA a garantizar la fiabilidad y precisión de sus aplicaciones.

🔹 Desarrolladores de software que buscan validar modelos LLM de forma sistemática

🔹 Ingenieros de control de calidad encargados de tests de IA y regresiones

🔹 Gerentes de producto que necesitan métricas claras para tomar decisiones

🔹 Científicos de datos interesados en evaluar y comparar resultados de LLM

BenchLLM dispone de una API para integración programática, permitiendo su uso en pipelines personalizados y otras herramientas. Encuentra documentación detallada, ejemplos de configuración CLI y guías de inicio rápido en el repositorio oficial de GitHub. Además, sigue las actualizaciones y participa en la comunidad a través de su cuenta de Twitter.

Ultimas IAS Listadas

Otras recomendaciones

Apúntate ya

Newsletter!