Ultimas IAS Listadas

Otras recomendaciones

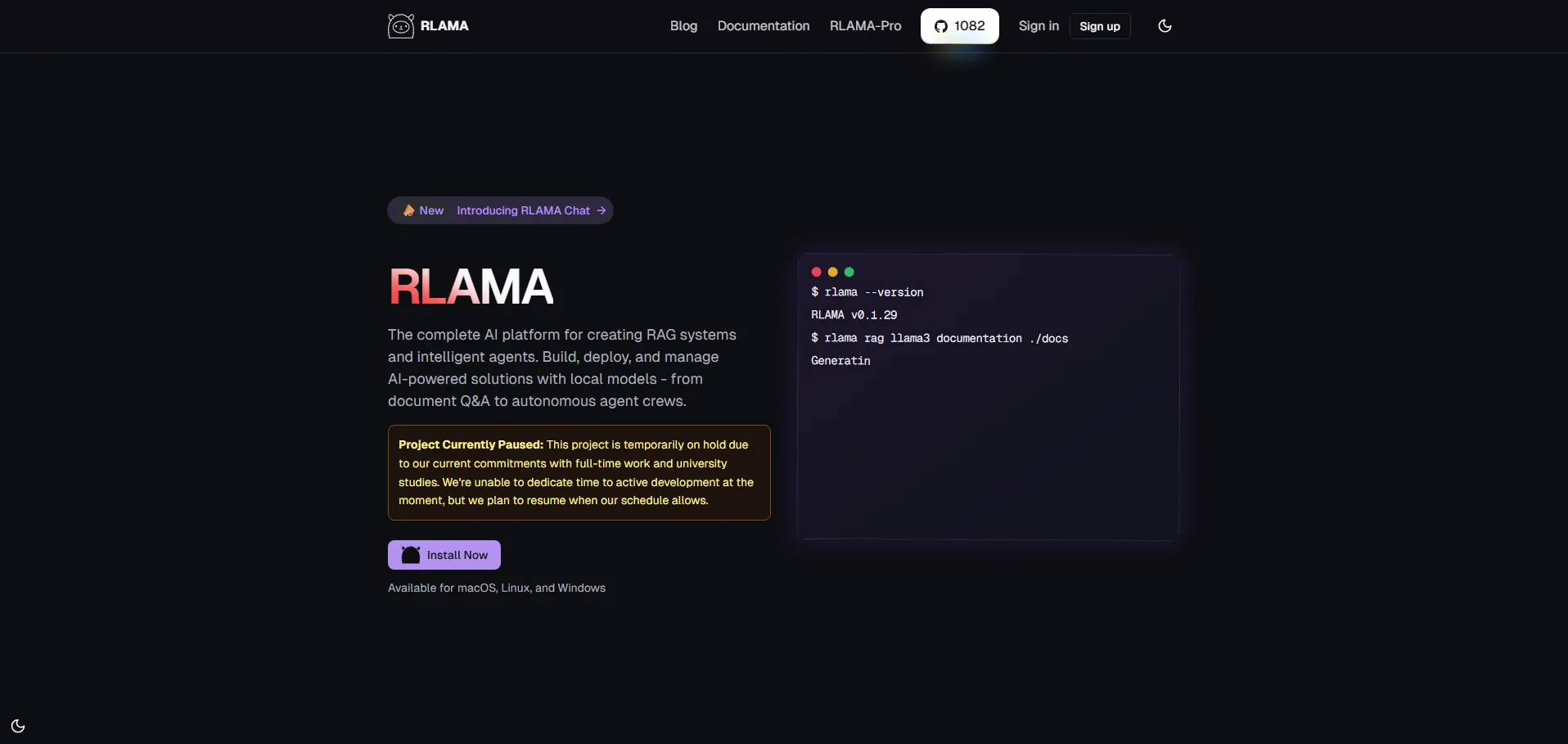

RLAMA es una herramienta de preguntas y respuestas para documentos que interactúa con los modelos locales de Ollama. Con su sistema de generación aumentada de recuperación (RAG), fragmentación inteligente de contenido y análisis profundo, permite crear, gestionar y consultar bases de conocimiento seguras a partir de PDF, Markdown y archivos de texto. El procesamiento se realiza completamente en local, garantizando privacidad y mantenimiento de la seguridad de los datos. Su interfaz de línea de comandos y compatibilidad con múltiples modelos de incrustación ofrecen flexibilidad y personalización en entornos técnicos y académicos.

🔹 Profesionales de TI: para consultar manuales, guías y documentación técnica con rapidez.

🔹 Investigadores académicos: para extraer citas y secciones relevantes de papers y notas.

🔹 Analistas de datos: para recuperar insights de grandes volúmenes de archivos de texto.

🔹 Equipos de seguridad y cumplimiento: para procesar datos sensibles localmente.

🔹 Departamentos de soporte y atención al cliente: para mantener bases de conocimiento siempre actualizadas.

RLAMA cuenta con una API para integración programática, ideal para desarrolladores que deseen incorporar consultas RAG en sus propias aplicaciones. Encuentra la documentación completa, tutoriales y el código fuente en el repositorio oficial de GitHub. Únete a la comunidad en Discord para soporte y noticias, o sigue las novedades en Twitter.

Apúntate ya

Newsletter!