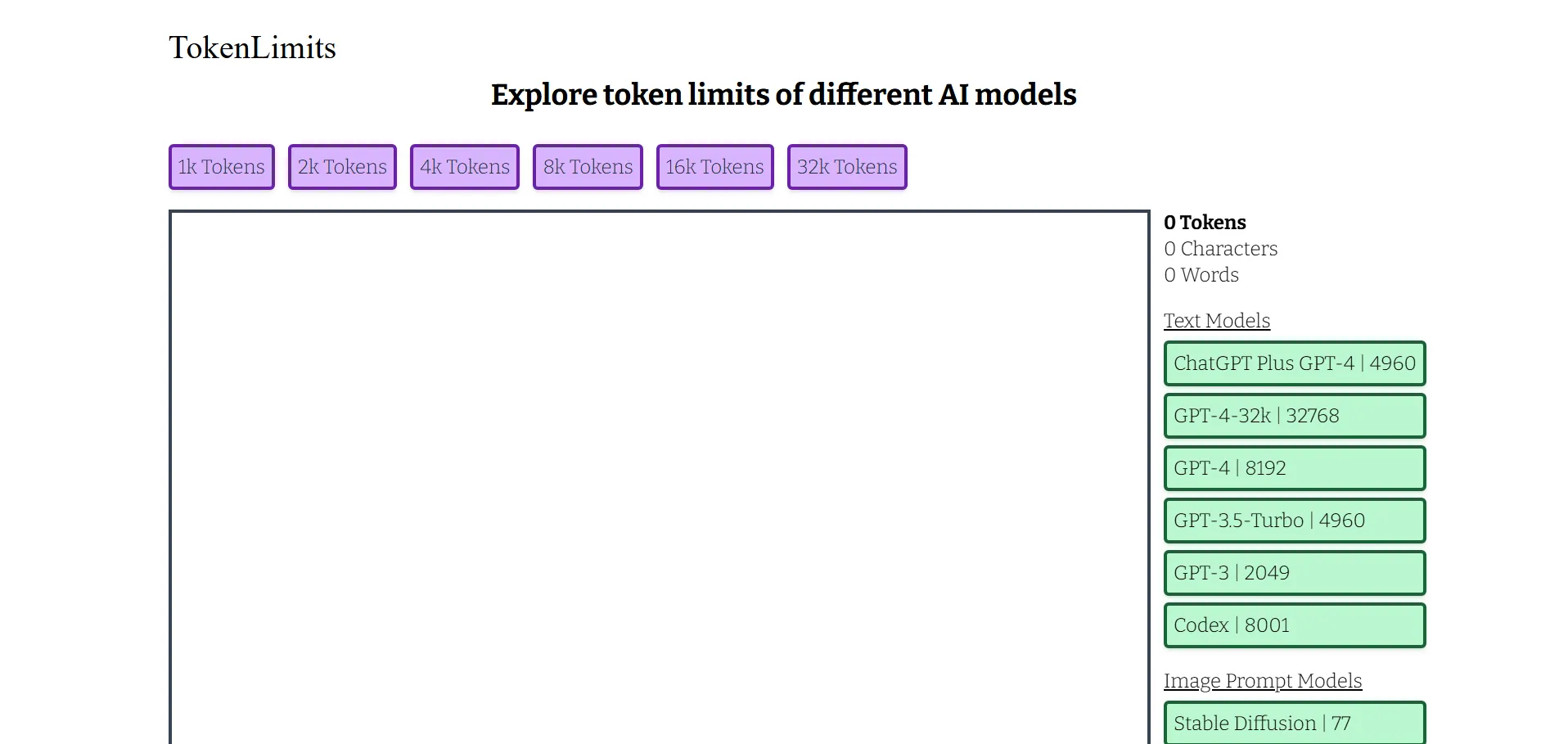

Tokenlimits es una herramienta que muestra los límites de tokens de diferentes modelos de IA, desde 1k hasta 32k, como GPT-4 y GPT-3.5-turbo. Facilita a desarrolladores e investigadores conocer la capacidad máxima de entrada de cada modelo para optimizar el uso en proyectos de lenguaje e imágenes.

🔹 Desarrolladores de aplicaciones de IA que necesitan ajustar la entrada de datos.

🔹 Investigadores que requieren conocer las capacidades de diversos modelos de lenguaje e imagen.

Accede al sitio oficial de Tokenlimits para consultar documentación, actualizaciones y soporte técnico.

Ultimas IAS Listadas

Apúntate ya

Newsletter!