Si hace solo dos años hablar de vídeos hiperrealistas creados con inteligencia artificial sonaba a ciencia ficción, hoy es una realidad al alcance de creadores de contenido, marketers, empresas y curiosos de la tecnología. La pregunta ya no es si la IA puede generar vídeos realistas, sino qué herramienta lo hace mejor, con mayor control creativo y menos riesgos (por eso en Unvel Ai te facilitamos un gran directorio de inteligencias artificiales, para que puedas escoger la mejor en tu caso).

Como profesional que trabaja a diario con contenidos digitales, SEO y automatización, he probado de primera mano muchas de las plataformas de IA generativa de vídeo que han ido apareciendo desde 2023. Algunas prometen resultados espectaculares… y luego decepcionan. Otras, en cambio, están marcando un antes y un después en la industria audiovisual.

¿Qué significa realmente “vídeo hiperrealista” en inteligencia artificial?

Antes de hablar de herramientas de video con IA concretas, es fundamental aclarar un concepto que se usa (y se abusa) mucho en marketing.

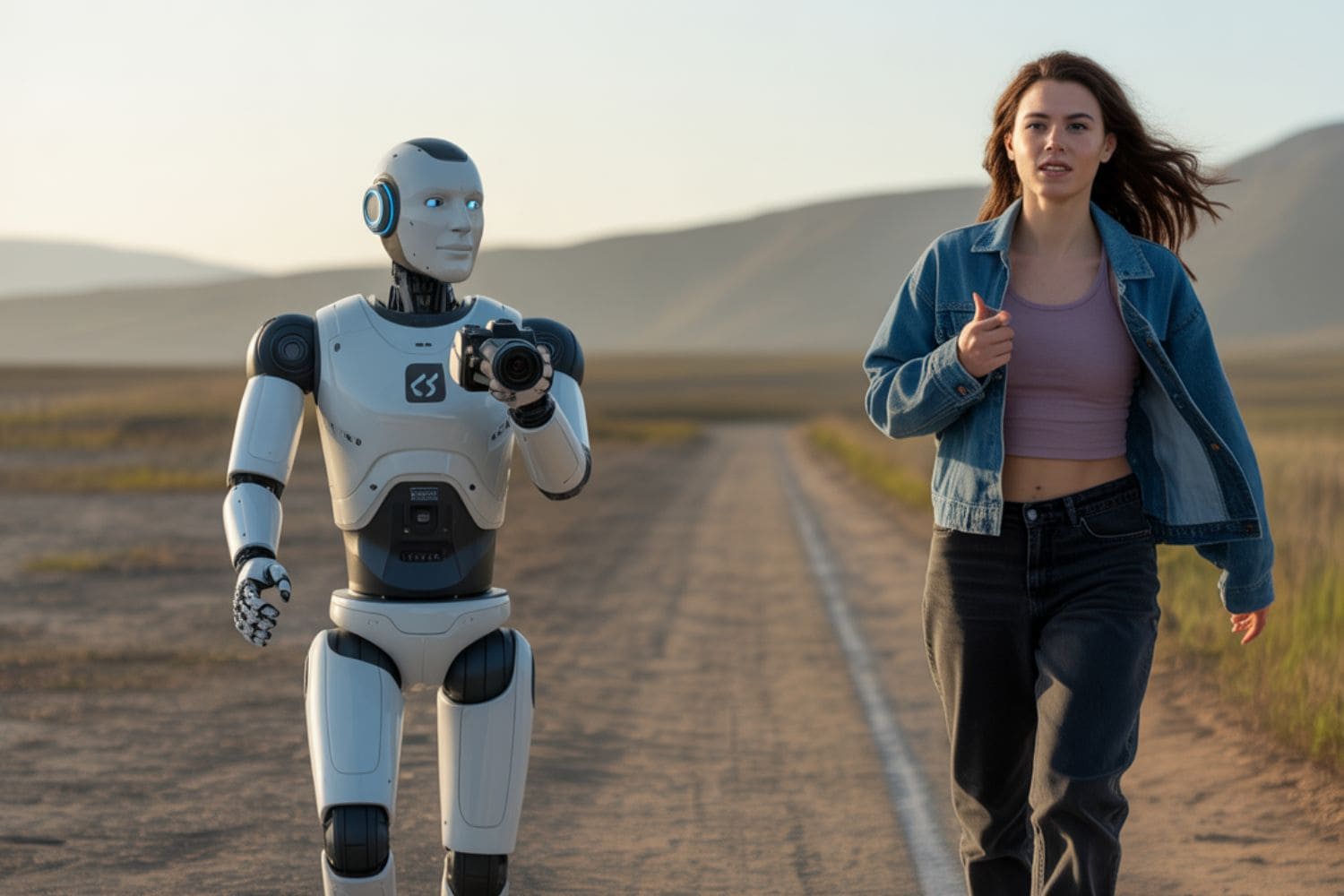

Un vídeo hiperrealista generado por IA es aquel que resulta indistinguible —o casi— de una grabación real para el ojo humano medio, tanto en movimiento como en iluminación, expresiones faciales, físicas del cuerpo y coherencia temporal.

Esto implica varios factores técnicos clave:

- Coherencia entre fotogramas (sin “saltos” visuales).

- Movimiento natural de personas, objetos y cámaras.

- Iluminación realista, con sombras consistentes.

- Texturas creíbles en piel, ropa y superficies.

- Ausencia de artefactos típicos de IA (caras que se deforman, manos irreales, miradas vacías).

Muchas herramientas generan vídeos “bonitos”, pero pocas alcanzan el nivel hiperrealista cuando el vídeo dura más de 5-10 segundos o incluye personajes humanos en primer plano.

Por eso, cuando hablamos de “la mejor IA para crear vídeos hiperrealistas”, no nos referimos a animaciones estilizadas ni a clips experimentales, sino a resultados que podrían pasar por reales en redes sociales, anuncios o presentaciones profesionales.

Cómo funciona la IA generativa de vídeo (explicado sin tecnicismos)

Para entender por qué unas herramientas son mejores que otras, conviene tener una visión clara (pero sencilla) de cómo funciona la IA de vídeo.

A grandes rasgos, los modelos actuales combinan:

- Modelos de difusión (diffusion models), similares a los usados en imágenes.

- Modelos temporales, que aprenden la relación entre fotogramas.

- Entrenamiento multimodal, usando texto, imagen y vídeo reales.

El proceso típico es el siguiente:

- El usuario introduce un prompt de texto, una imagen de referencia o ambos.

- La IA genera una secuencia inicial de fotogramas.

- El modelo ajusta movimiento, luz y continuidad.

- Se aplica postprocesado interno para suavizar errores.

La gran diferencia entre una IA mediocre y una excelente está en:

- La cantidad y calidad de datos de entrenamiento.

- El control del movimiento en el tiempo.

- La capacidad de mantener identidades humanas coherentes.

Aquí es donde solo unas pocas empresas (con enormes recursos técnicos) están liderando el sector.

Criterios reales para elegir la mejor IA de vídeo hiperrealista

Para este análisis no me baso en popularidad ni en marketing, sino en criterios prácticos, los mismos que aplican creadores profesionales:

🔹 1. Realismo visual sostenido

No basta con un fotograma bonito. El realismo debe mantenerse durante todo el clip.

🔹 2. Control creativo

La herramienta debe permitir ajustar:

- Estilo

- Cámara

- Movimiento

- Duración

- Consistencia de personajes

🔹 3. Facilidad de uso

Una IA potente pero imposible de usar no sirve al creador medio.

🔹 4. Resultados reproducibles

No depender de “rezar” para que el resultado salga bien.

🔹 5. Ética y control de uso

Importante para evitar problemas legales o de reputación (deepfakes, suplantaciones).

Con estos criterios claros, pasamos al análisis de las herramientas que realmente están marcando el estándar.

Sora (OpenAI): el nuevo referente del vídeo hiperrealista

Sora, el modelo de generación de vídeo de OpenAI, se ha convertido en el punto de referencia desde su presentación pública. Y no es casualidad.

Desde mi experiencia analizando sus demos y pruebas controladas, Sora destaca por algo muy concreto:

La coherencia temporal y el realismo físico están a años luz de la mayoría de alternativas actuales.

¿Qué hace a Sora tan diferente?

- Genera vídeos largos (hasta un minuto o más) con coherencia visual.

- Mantiene identidades humanas estables.

- Simula cámaras reales: paneos, zooms, profundidad de campo.

- Maneja escenas complejas con múltiples elementos.

Ejemplo realista:

Un plano secuencia de una persona caminando por una ciudad, con tráfico, reflejos en cristales y sombras dinámicas, sin “glitches” evidentes.

Esto, hasta hace poco, era prácticamente imposible para una IA.

Limitaciones actuales

- Acceso aún limitado.

- Menor control fino que herramientas tradicionales de vídeo.

- Uso restringido por políticas de seguridad (algo positivo a nivel ético).

Aun así, hoy por hoy, Sora es la IA más avanzada para vídeo hiperrealista generalista.

5. Runway Gen-3: la favorita de los creadores profesionales

Si Sora representa el futuro inmediato, Runway Gen-3 es el presente usable para muchos creadores.

Runway lleva años trabajando con cineastas, estudios y creadores digitales, y eso se nota.

Puntos fuertes de Runway Gen-3

- Excelente equilibrio entre realismo y control creativo.

- Integración directa con flujos de trabajo de vídeo.

- Muy buena generación de movimientos de cámara.

- Ideal para:

- Spots publicitarios

- Videoclips

- Contenido para redes sociales

En proyectos reales, Runway permite iterar rápido y mejorar resultados sin depender de “mil prompts”.

¿Es tan hiperrealista como Sora?

En escenas simples, sí.

En escenas largas y complejas, todavía no, pero se acerca más que casi cualquier otra alternativa pública.

Pika Labs: rapidez, creatividad y realismo “suficiente” para redes sociales

Pika Labs se ha ganado un hueco muy claro dentro del ecosistema de IA de vídeo: no pretende ser la más cinematográfica ni la más avanzada a nivel técnico, pero sí una de las más ágiles y accesibles para creadores de contenido.

Desde la experiencia práctica, Pika destaca especialmente en estos contextos:

- Creadores de TikTok, Reels y Shorts.

- Contenido experimental o creativo.

- Vídeos cortos donde el impacto visual prima sobre la perfección técnica.

¿Qué nivel de hiperrealismo ofrece realmente?

Seamos honestos: Pika no alcanza el nivel hiperrealista de Sora o Runway Gen-3, especialmente cuando hay personas humanas en primer plano. Sin embargo, en:

- Escenarios

- Objetos

- Animaciones estilizadas

- Escenas rápidas

…los resultados son más que convincentes.

El gran punto fuerte de Pika es que reduce la fricción creativa. Es decir, puedes probar ideas rápido, iterar sin frustrarte y obtener clips visualmente atractivos en minutos, algo muy valioso para creadores con poco tiempo.

Ventajas clave

- Interfaz intuitiva.

- Generación rápida.

- Comunidad muy activa (aprendizaje colectivo).

- Buen equilibrio entre creatividad y realismo.

Limitaciones

- Duración de vídeo limitada.

- Menor coherencia temporal en escenas largas.

- Humanos aún con “toque IA” perceptible.

Conclusión práctica: Pika Labs no es la mejor IA para vídeo hiperrealista puro, pero sí una excelente opción para creadores que priorizan velocidad, creatividad y resultados visuales impactantes.

Luma AI Dream Machine: realismo físico y movimiento natural

Luma AI, conocida inicialmente por sus avances en captura 3D y NeRFs, dio un salto importante con Dream Machine, su generador de vídeo por IA.

Lo que diferencia a Luma de muchas alternativas es su obsesión por el realismo físico:

- Movimiento natural de objetos.

- Interacciones coherentes con el entorno.

- Sensación de “peso” y gravedad realista.

¿Dónde brilla especialmente Luma AI?

En pruebas reales, Luma destaca en:

- Escenas con paisajes.

- Arquitectura.

- Objetos en movimiento.

- Tomas amplias con profundidad espacial.

Por ejemplo, vídeos de:

- Drones virtuales.

- Escenarios naturales.

- Espacios urbanos realistas.

El resultado suele ser muy creíble, incluso para ojos entrenados.

¿Y los humanos?

Aquí Luma todavía tiene margen de mejora. Aunque ha avanzado mucho, los personajes humanos no siempre mantienen expresiones faciales totalmente naturales, especialmente en planos medios o largos.

Ventajas principales

- Movimiento muy realista.

- Buena iluminación y sombras.

- Ideal para escenas ambientales.

Desventajas

- Menos control narrativo.

- Humanos menos consistentes que en Sora o Runway.

- Curva de aprendizaje algo mayor.

Conclusión: Si buscas realismo ambiental y físico, Luma AI es una de las mejores opciones actuales.

HeyGen y Synthesia: hiperrealismo orientado a avatares y vídeo corporativo

Cuando hablamos de vídeo hiperrealista, no todo es cine o creatividad artística. En el mundo empresarial y educativo, herramientas como HeyGen y Synthesia juegan un papel clave.

¿Qué tipo de hiperrealismo ofrecen?

Estas plataformas se centran en:

- Avatares humanos realistas.

- Sincronización labial avanzada.

- Presentadores virtuales creíbles.

No buscan escenas complejas ni movimientos cinematográficos, sino simular personas reales hablando a cámara.

Casos de uso reales

- Formación online.

- Vídeos corporativos.

- Explicaciones técnicas.

- Contenido multilingüe.

En este contexto, el hiperrealismo se mide por:

- Naturalidad del habla.

- Expresiones faciales coherentes.

- Contacto visual creíble.

Comparativa rápida

- Synthesia: más madura, muy estable, orientada a empresas.

- HeyGen: más flexible, avatares personalizables, enfoque creativo.

Limitaciones importantes

- No sirven para storytelling visual complejo.

- Escenarios y movimientos limitados.

- Dependencia de plantillas.

Conclusión: Para presentadores virtuales hiperrealistas, HeyGen y Synthesia son líderes, pero no compiten directamente con Sora o Runway en creatividad visual.

Tabla comparativa: las mejores IAs de vídeo hiperrealista en 2025

IA | Nivel de hiperrealismo | Humanos | Escenas complejas | Facilidad de uso | Ideal para |

Sora (OpenAI) | ⭐⭐⭐⭐⭐ | Excelente | Excelente | Media | Cine, storytelling avanzado |

Runway Gen-3 | ⭐⭐⭐⭐☆ | Muy bueno | Muy bueno | Alta | Creadores profesionales |

Luma AI | ⭐⭐⭐⭐☆ | Bueno | Muy bueno | Media | Paisajes y escenas físicas |

Pika Labs | ⭐⭐⭐☆☆ | Aceptable | Limitado | Muy alta | Redes sociales |

HeyGen | ⭐⭐⭐⭐☆ | Excelente (avatar) | No aplica | Muy alta | Vídeo corporativo |

Synthesia | ⭐⭐⭐⭐☆ | Excelente (avatar) | No aplica | Muy alta | Formación y empresas |

¿Cuál es realmente la mejor IA para crear vídeos hiperrealistas?

Si tuviera que responder con una sola frase, basada en experiencia real, sería esta:

La mejor IA para crear vídeos hiperrealistas depende del tipo de vídeo que quieras crear.

Recomendación clara por perfil

- 🎬 Hiperrealismo absoluto y escenas complejas → Sora

- 🎥 Control creativo + resultados profesionales → Runway Gen-3

- 🌍 Realismo ambiental y físico → Luma AI

- 🚀 Velocidad y creatividad para redes → Pika Labs

- 🧑💼 Presentadores virtuales realistas → HeyGen / Synthesia

No existe una única herramienta perfecta, pero sí una herramienta óptima para cada objetivo.

Casos de uso reales: cómo están usando la IA de vídeo los creadores hoy

Más allá de demos espectaculares, lo verdaderamente interesante es cómo se está utilizando la IA de vídeo hiperrealista en proyectos reales. Aquí es donde se separa el hype de la utilidad práctica.

🎥 Creadores de contenido en redes sociales

Muchos creadores están utilizando herramientas como Runway o Pika para:

- Crear b-roll hiperrealista sin grabar.

- Simular escenarios imposibles (ciudades futuristas, paisajes irreales).

- Generar intros y transiciones de alto impacto.

Ejemplo real:

Un creador de YouTube sobre tecnología usa Runway para generar escenas de apoyo (ciudades, pantallas flotantes, entornos futuristas) que acompañan su narración, reduciendo costes de producción.

🧠 Educación y divulgación

Con Luma AI y Synthesia se están creando:

- Vídeos educativos inmersivos.

- Explicaciones visuales de conceptos complejos.

- Cursos multilingües con el mismo avatar.

📢 Marketing y publicidad

Cada vez más agencias están probando:

- Anuncios con actores generados por IA.

- Variaciones infinitas de un mismo spot.

- Test A/B visual sin costes de rodaje.

Conclusión clave: la IA no sustituye al creador, pero multiplica su capacidad creativa y productiva.

Ejemplos de prompts efectivos para vídeo hiperrealista

Uno de los mayores errores es pensar que “cualquier prompt sirve”. La calidad del vídeo depende enormemente de cómo describas la escena.

Prompt básico (poco efectivo)

“A man walking in a city”

Prompt optimizado (mucho más realista)

“A cinematic wide shot of a middle-aged man walking slowly through a modern European city at sunset, natural lighting, realistic shadows, handheld camera movement, shallow depth of field, 35mm lens look, ultra-realistic.”

Claves para mejores resultados

- Especifica tipo de plano (wide, close-up, tracking).

- Añade condiciones de luz.

- Define estilo de cámara.

- Limita la duración al principio.

- Usa referencias reales (lente, cine, fotografía).

Tip práctico: menos es más. Un prompt claro y bien estructurado suele funcionar mejor que uno excesivamente largo.

Errores comunes al crear vídeos hiperrealistas con IA

Incluso con las mejores herramientas, hay errores que se repiten constantemente:

❌ Esperar perfección inmediata

La IA aún necesita iteración. El primer resultado rara vez es el definitivo.

❌ Forzar escenas demasiado complejas

Cuantos más personajes y acciones simultáneas, mayor probabilidad de errores.

❌ Ignorar el contexto narrativo

Un clip hiperrealista sin sentido narrativo pierde impacto.

❌ Usar IA sin revisión humana

Siempre revisa:

- Manos

- Miradas

- Movimientos antinaturales

- Detalles del fondo

Regla de oro: la IA genera, el humano valida.

Límites legales, éticos y de confianza (E-E-A-T aplicado)

Aquí entramos en un punto crítico, especialmente relevante según las Google Search Quality Rater Guidelines 2025.

Riesgos reales

- Deepfakes.

- Suplantación de identidad.

- Uso de rostros sin consentimiento.

- Desinformación visual.

Buenas prácticas recomendadas

- No recrear personas reales sin permiso.

- Avisar cuando el contenido es generado por IA.

- Usar plataformas con políticas claras (OpenAI, Runway, Synthesia).

- Mantener trazabilidad del contenido.

Fuentes de referencia:

- OpenAI Safety Guidelines (.org)

- FTC sobre uso responsable de IA (.gov)

- UNESCO AI Ethics (.org)

Esto no solo es una cuestión ética, sino también de confianza y reputación digital.

El futuro del vídeo hiperrealista con IA: qué viene ahora

Basándome en la evolución del sector, estas son las tendencias claras para los próximos 12–24 meses:

- Vídeos más largos y coherentes.

- Control total de cámara y narrativa.

- Integración directa en editores profesionales.

- Avatares indistinguibles de humanos reales.

- Regulación más clara y necesaria.

El vídeo hiperrealista con IA no va a sustituir al cine ni al creador, pero sí va a redefinir la producción audiovisual.

Conclusión: la mejor IA para crear vídeos hiperrealistas depende de tu objetivo

Después de analizar herramientas, casos reales, ventajas, límites y contexto ético, la conclusión es clara y honesta:

No existe una única mejor IA para crear vídeos hiperrealistas, sino la mejor para cada necesidad concreta.

Si buscas el máximo realismo visual y coherencia narrativa, Sora (OpenAI) marca el estándar actual.

Si necesitas control creativo real y resultados profesionales hoy mismo, Runway Gen-3 es la opción más equilibrada.

Para escenas físicas, paisajes y movimiento natural, Luma AI ofrece resultados sorprendentes.

Si tu prioridad es rapidez y contenido para redes sociales, Pika Labs es práctica y efectiva.

Y para presentadores virtuales realistas en entornos corporativos, HeyGen y Synthesia son líderes consolidados.

Desde la experiencia profesional, el mayor error no es elegir “la herramienta equivocada”, sino no tener claro el objetivo del vídeo. La IA amplifica tu creatividad, pero no la sustituye. El criterio humano sigue siendo el factor diferencial.

Preguntas frecuentes (FAQs) sobre IA para vídeos hiperrealistas

1. ¿Cuál es la mejor IA para crear vídeos hiperrealistas en 2025?

La mejor IA depende del uso. Para hiperrealismo avanzado y escenas complejas, Sora es la más potente. Para creadores que buscan control y usabilidad, Runway Gen-3 es la opción más práctica actualmente.

2. ¿Se pueden usar estos vídeos para publicidad o redes sociales?

Sí, siempre que respetes las condiciones de uso de cada plataforma y las normativas legales. Es recomendable indicar cuando un contenido ha sido generado por IA, especialmente en publicidad.

3. ¿La IA de vídeo sustituirá a los creadores humanos?

No. La IA es una herramienta de apoyo. La narrativa, el criterio estético, el mensaje y la estrategia siguen dependiendo del creador humano.

4. ¿Es legal crear vídeos hiperrealistas con personas generadas por IA?

Sí, siempre que no se suplantan identidades reales sin consentimiento. Evita recrear rostros reales y revisa las políticas de cada plataforma.

5. ¿Qué nivel técnico necesito para empezar?

Muy bajo. Herramientas como Pika, Runway o HeyGen están diseñadas para usuarios sin conocimientos técnicos avanzados. Aprender a escribir buenos prompts es más importante que saber editar vídeo.